NVIDIAは、そのGPUでAIの実力をコンシューマーに提供する最前線に立っており、今後数年間で、ゲームとグラフィックの忠実性の新時代を切り開くいくつかの新技術が登場する。

NVIDIAのDLSS 3.5とRay Reconstructionは始まりに過ぎず、コンシューマー向けGPUがピクセルを生成する方法を根本的に変えるであろう、いくつかの次世代AI技術について同社は語っている。

MicrosoftやAmazonのような大手ハイテク企業が、高度なコンピューティングや消費者体験の向上など、AI技術がもたらす大きなメリットのために、AI統合の競争を繰り広げていることを考えると、人工知能が人間の世界で知られているあらゆる主流アプリケーションに流入することは、間近に迫っているように見える。

しかし、NVIDIAは、コンピューティングとエンタープライズ・アプリケーションにおけるAIの活用という点ではトップレベルにあり、その顕著な例がNVIDIAのACEである。

NVIDIAは現在、AIがもたらすパワーをグラフィック性能の強化に取り込む決意を固めているようだ。

この投稿はメインストリームのニュースではなく、AIがGPUのグラフィック性能においていかに大きな役割を果たすか、そして最終的に開発者がアイデアを “グラフィック “で可視化する方法に新たな扉を開くことを示す一連の出来事を物語るものである。

NVIDIAのRay Reconstruction: RTとAIを1つのパッケージに統合し、ビジュアルを大幅に強化

グラフィックスの現代において、競争は、NVIDIAのDLSSやAMDのFSRのような「人工的に燃料を供給する」手段を通じて、消費者が最高のシナリオを見ることができるように、アーキテクチャがネイティブ解像度をいかにアップスケールできるかにある。

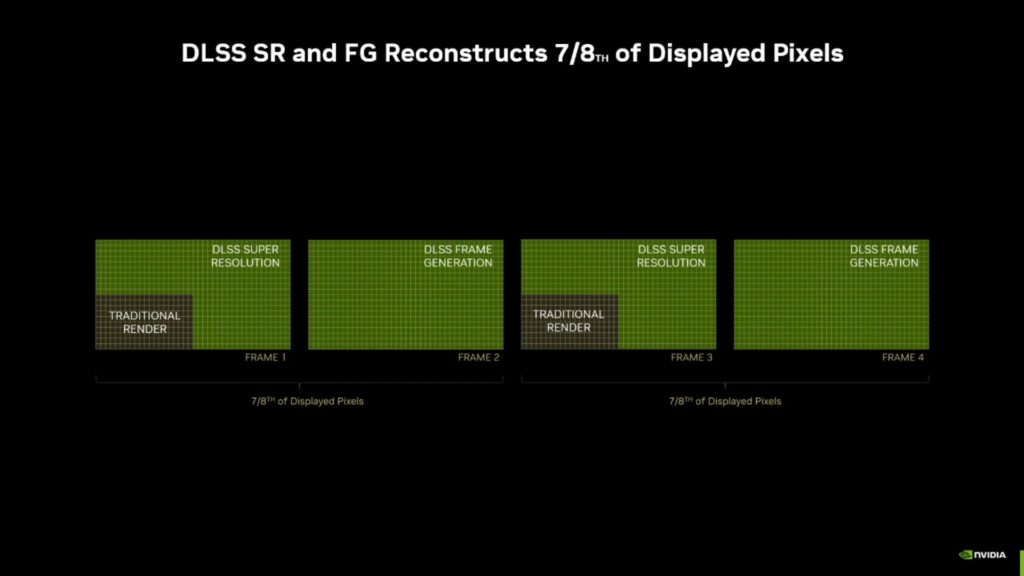

NVIDIAは、AIの流入により、ユーザーに表示される「7~8」ピクセルを強化することに成功し、場合によっては解像度を「4倍」にできる可能性があると述べている。

これにより、同社は開発者がDLSSのパワーを使って古いタイトルを「再創造」できるようにした。

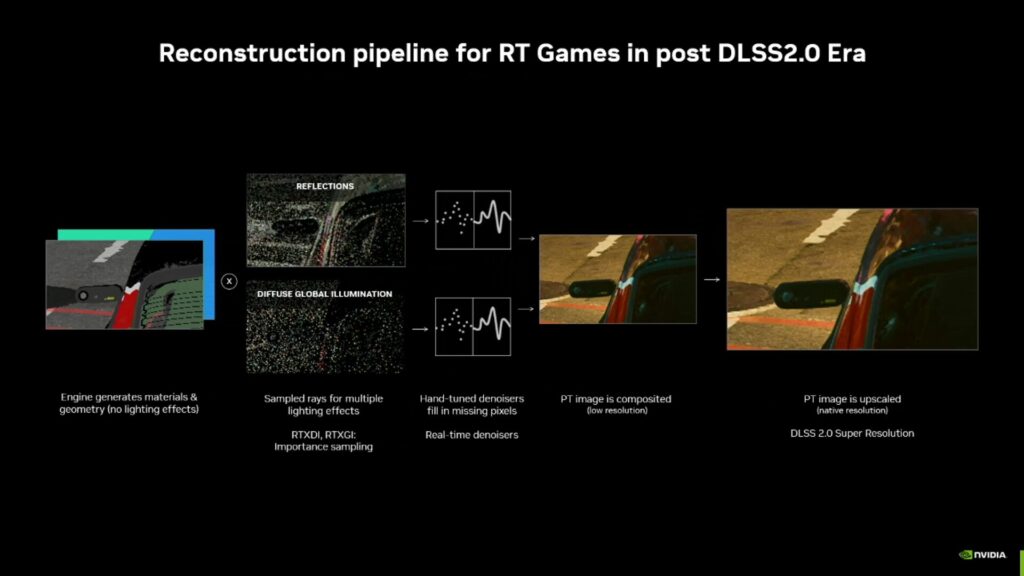

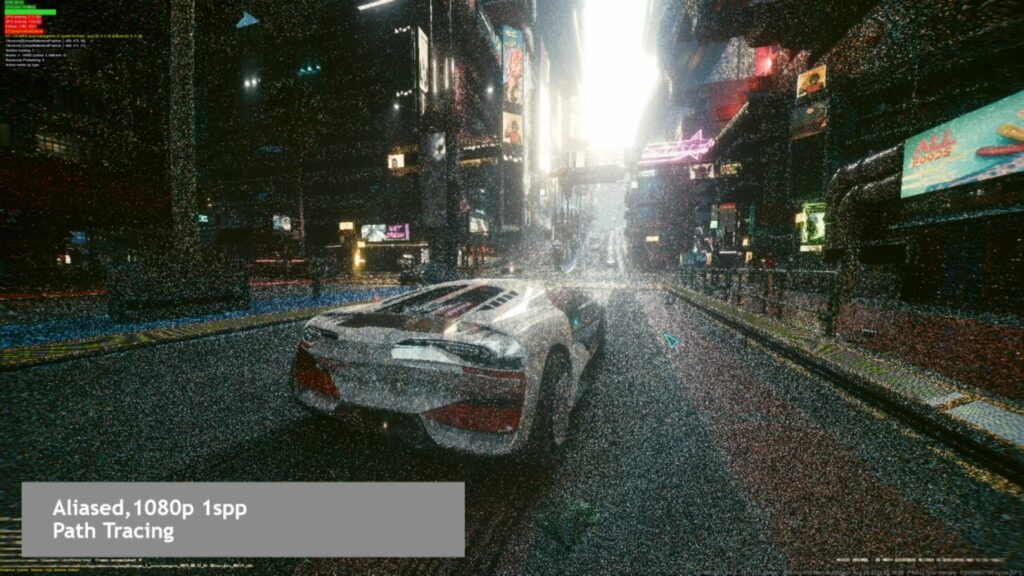

少し背景を確認しておくと、NVIDIAの以前のレイトレーシング・パイプラインは、DLSS 2のような技術で我々が見た結果を達成するために、ノイズ除去器(ノイズ・アーティファクトを除去するために使用される)からアンチエイリアシング・フィルタに至るまで、いくつかの要素に依存していました。

これは仕事をする一方で、パイプラインが単純な言語でそれをサポートすることができなかったため、開発者は「画像のアップスケーリング」による利点を活用することができませんでした。

そのため、画像のアップスケーリングの統合が必要となり、そのためにNVIDIAは “Ray Reconstruction “の導入を決定した。

この特別なメカニズムは、レイトレーシング・パイプラインの扱い方を変え、代わりに “ユニファイド・デノイザー “アプローチが採用された。

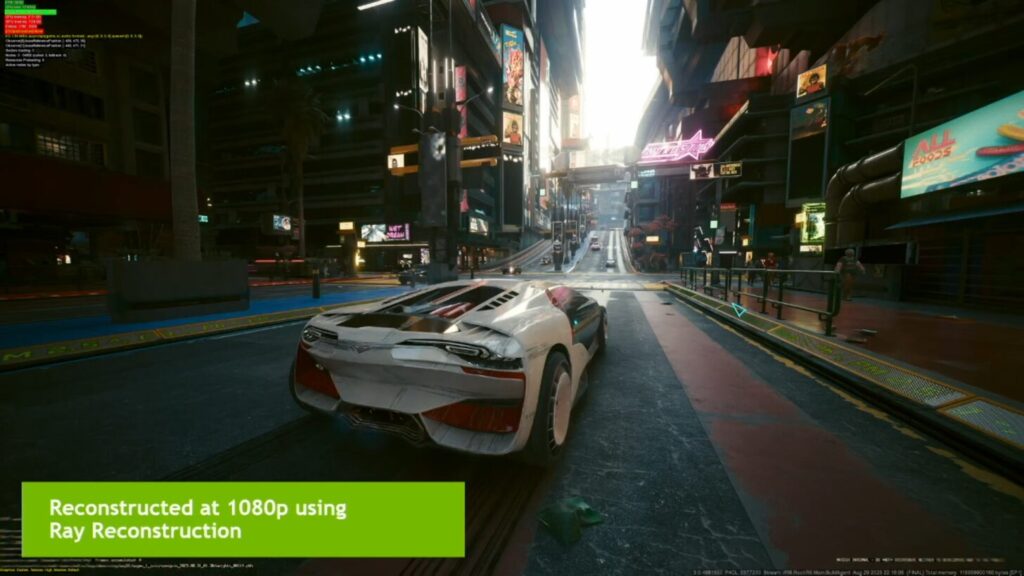

Ray Reconstructionは、動く影、光源、オブジェクトなどの非常に動的な信号を処理するように設計された複数のAIモデルを採用し、その見返りとして、手作りのノイズ除去器と比較して大幅に改善されたパフォーマンスを提供します。

レイ・コンストラクションは、レイトレーシングのプロセスを最適化することで、すべてのコンシューマーがアクセスできるようにし、場合によってはハードウェアの制限を取り払うことさえできる。

それだけでなく、グラフィック計算の境界を取り払ったことで、開発者は見事なビジュアルを提供し、古典的なタイトルを再現して現代への「グラフィック移行」を確実にすることさえできる。

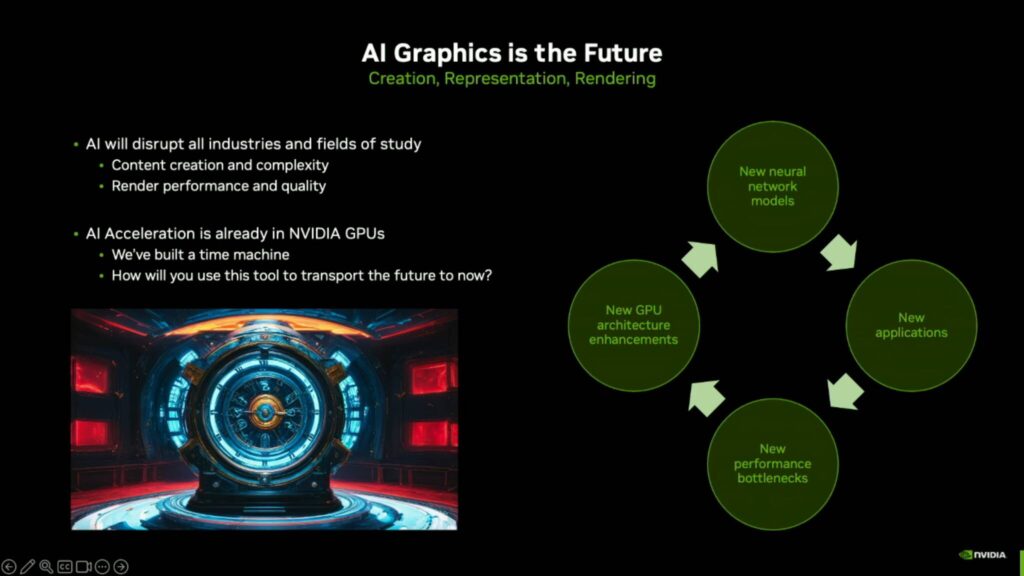

AIグラフィックスにおけるNVIDIAの次のステップ

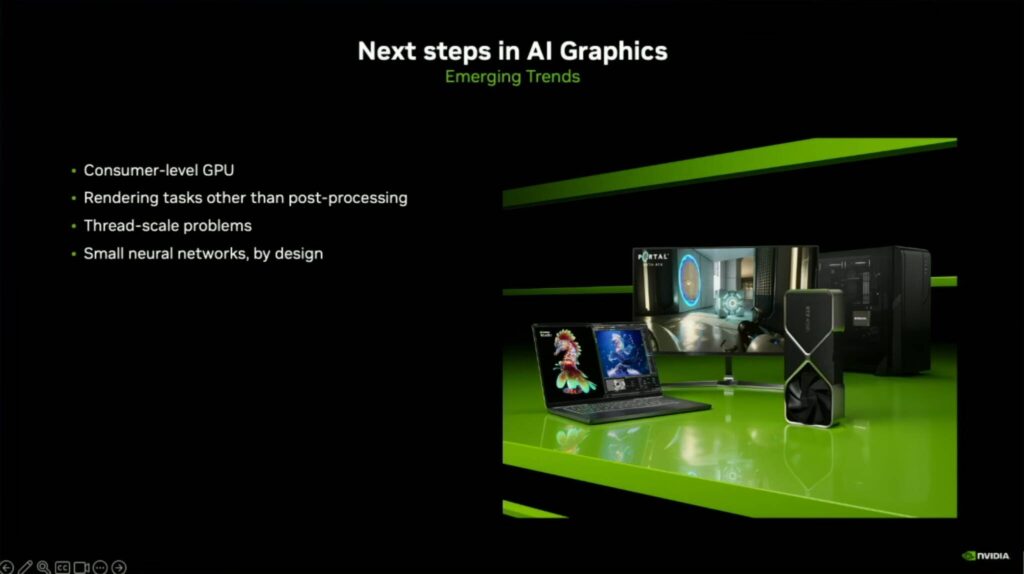

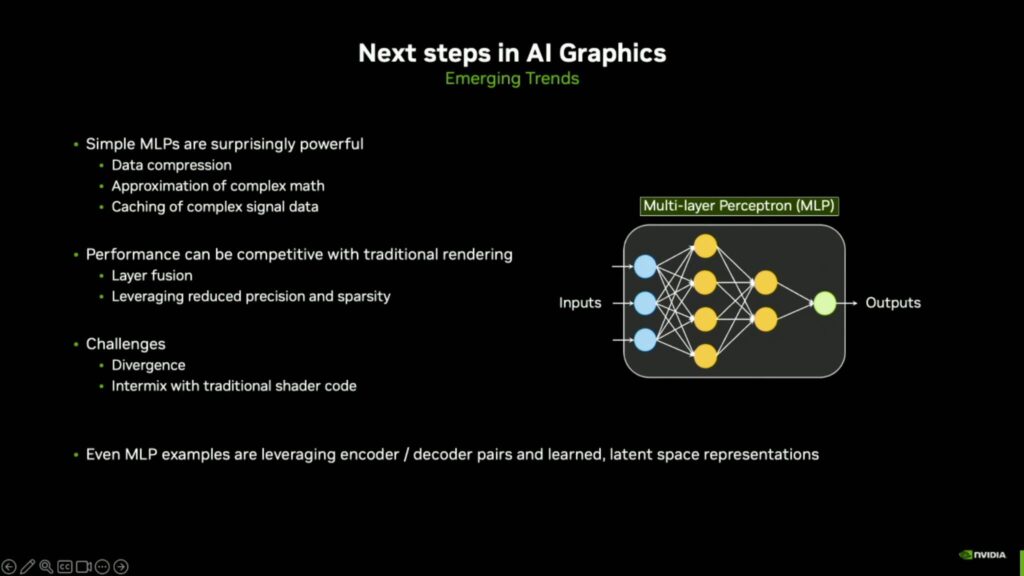

しかし、次に何が来るのだろうか?NVIDIAのJohn Burgess氏は最近、High-Performance Graphicsイベントの中で、AIグラフィックスの新たなトレンドのいくつかを強調し、特にGeForce向けRTXやワークステーション向けRTXといったコンシューマーレベルのGPUについて語った。

AIは、DLSSのような後処理以外のさまざまなレンダリング作業に役立つと言及されています。

これはIntelのTAP氏も示唆していたことで、AIの応用は単なるアップスケーリングやフレーム生成にとどまらないと見ている。

NVIDIAも同イベントでその例を示したが、これについては後ほど紹介する。

NVIDIAが提示した新しいアプローチには、以下のようなものがあります:

NVIDIA、Neural Texture Compression、NeuralVDB、Neural Radiance Cacheモデルでキャッシュとパフォーマンスを強化

グラフィックスの忠実度を高めるためにAIを活用する最初の例は、接続されたニューロンで構成される人工ニューラルネットワークである小型MLP(Multi-Layer Perceptron)を使用するNeural Texture Compressionです。

Neural Texture Compressionモデルは、マテリアルテクスチャスタックごとに1つのMLPネットワークを利用し、2つの隠し層を含みます。

このモデルは、標準的なブロック圧縮テクスチャ(BC)に対して4~16倍の圧縮率向上を可能にします。

これにより、同じメモリフットプリントでより高解像度のテクスチャが可能になり、より小さなメモリフットプリントで同等の解像度が得られるため、VRAM、帯域幅、キャッシュに制限のあるGPUで、より高解像度のテクスチャをより効率的に処理できるようになります。

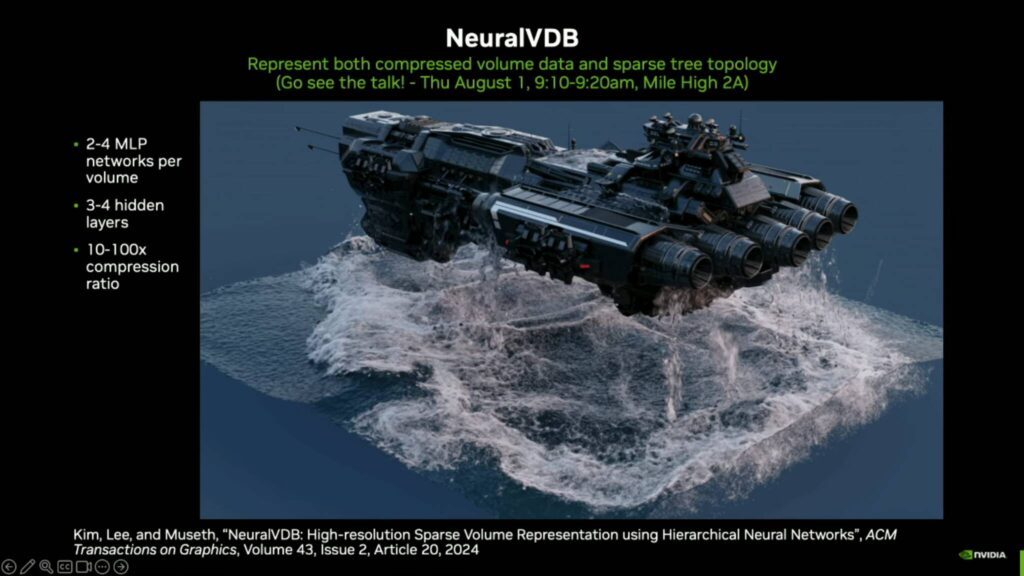

次にNeuralVDBは、圧縮されたボリュームデータとスパースツリートポロジーを表現します。

ボリュームあたり2~4個のMLPを3~4個の隠し層で利用し、10~100倍の圧縮率を実現する。

SIGGRAPH2022でNVIDIAは、このモデルを利用して、最大100倍のメモリフットプリント削減で複雑なボリュームシミュレーションを実行できることを紹介した。

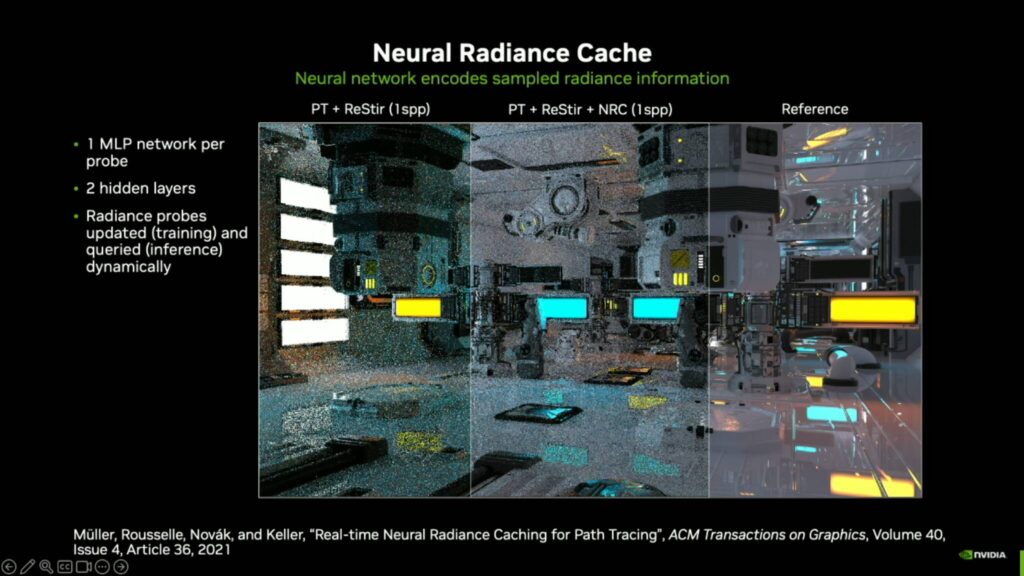

最後に、輝度情報をエンコードするためにニューラルネットワークを使用するニューラル・ラディアンス・キャッシュがある。

このモデルは、2つの隠し層を持つプローブごとに1つのMLPネットワークを使用し、プローブを動的に更新(トレーニング)およびクエリ(推論)することができます。

Neural Radiance CacheをPath Tracingレンダリングに追加すると、サンプルの品質が劇的に向上します。

これは、より高速な変換や、レンダリングのノイズ除去を容易にするのに役立ちます。

NVIDIAのリアルタイム・レンダリング強化計画には、ニューラル・アピアランス・モデルの利用が含まれており、これにより大幅な改善がもたらされる。

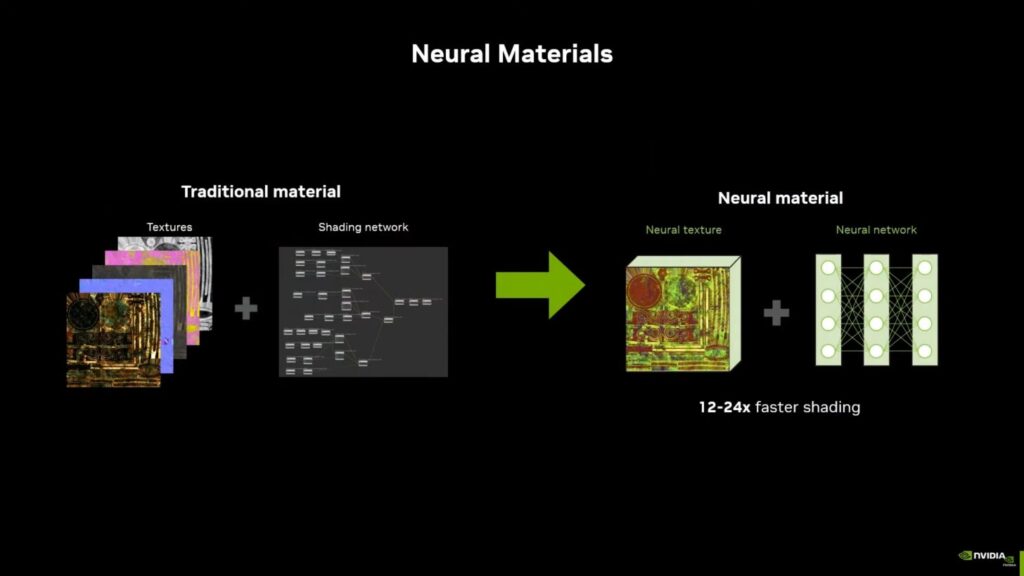

レイトレーシングが終わったところで、グラフィカル・コンピューティングの基本的な構成要素であるシェーディング・パフォーマンスとリアルタイム・レンダリングについて少し話をしよう。

NVIDIAは、このセグメントを整理するために、かなり興味深い方法を考え出しました。以前の報道で強調したように、同社はニューラル材料モデルの能力を活用しました。

今のところ、Team Greenはニューラルネットワークを、想像もしなかったような新たなレベルまでグラフィカル計算を強化できるような形で構築することに成功している。

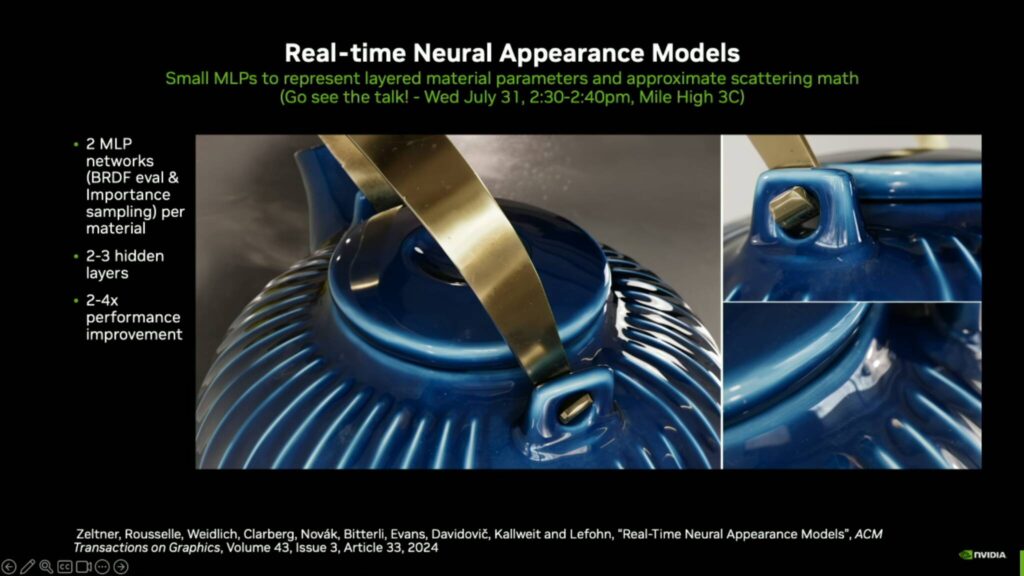

SIGGRAPH2024の基調講演で、NVIDIAはニューラル・アピアランス・モデル(Neural Appearance Models、NAMs)を紹介した。

NAMsはAIを活用し、従来のものから高度に最適化された手法によって、マテリアルの外観をよりリアルに表現してレンダリングする。

これらのニューラル・モデルは、現実世界のマテリアルの視覚的特性を知るように訓練されており、そのようなデータセットを画像のレンダリングに適用することで、非常にリアルであるだけでなく、はるかに高速な最終製品を作成します。

ニューラルネットワークの複雑さを説明することは、特に一般の読者にとっては十分に難しいことですが、ここでは最も効果的な方法で物事を要約してみます。

先ほど説明したニューラル・アピアランス・モデルは、2つのMLP(多層パーセプトロン)、1つはBRDF評価用、もう1つは重要度サンプリングとデータサンプリング用を含む特定のブロックの上に構築されていますが、まったく新しいレベルにスケールアップされています。

それとともに、NAMはエンコーダー・デコーダー・アーキテクチャーを利用し、入力データを処理し、データセットに沿ったパラメーターに基づいて最終的な素材の外観を生成する。

さて、NAMがどのように機能するのか、ある程度ご理解いただけたと思うので、興味深い部分である潜在的な能力に話を移そう。

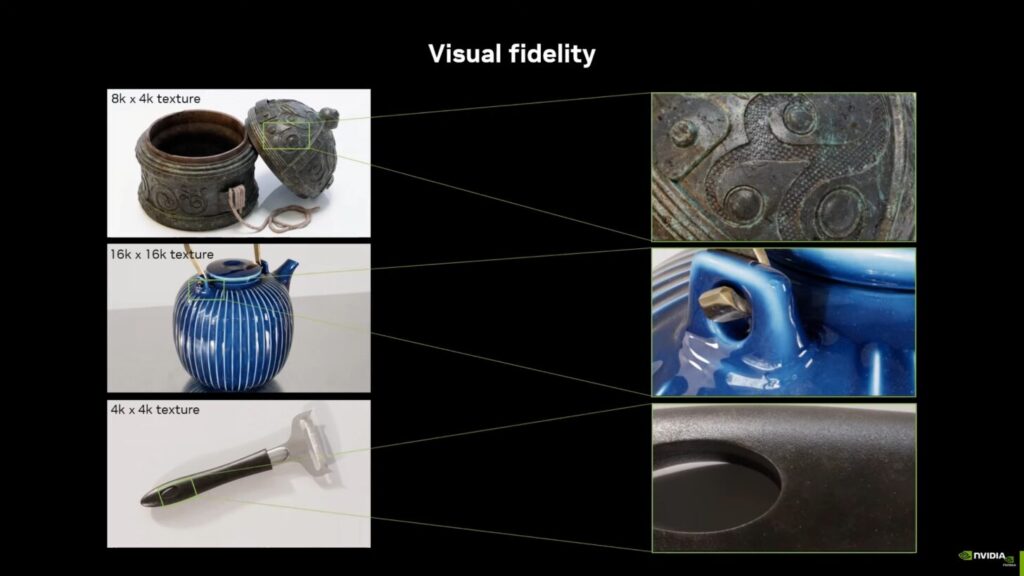

NVIDIAのニューラル・アピアランス・モデルのショーケースでは、最大16Kテクスチャ解像度のレンダリングが可能であることが明らかにされた。

これとは別に、搭載された計算効率の高いニューラル・ネットワークは、レンダリング時間をなんと12~24分の1に短縮すると言われており、従来のシェーディング・グラフ技術では不可能とされていたことを考えると、これまた巨大な成果である。

今後、NVIDIA、MLPとAI全般がグラフィックスの世界で大きな改善を達成できると考えている:

単純なMLPは驚くほど強力です:

- データ圧縮

- 複雑な数学の近似

- 複雑な信号データのキャッシュ

パフォーマンスは従来のレンダリングと遜色ない

- レイヤフュージョン

- 精度の低下とスパース性の活用

MLPは小さいため、その性能は従来のレンダリングと遜色なく、これらの機能強化が大きなコストになることはありません。

課題

- 乖離

- 従来のシェーダーコアとの混在

いくつかの課題にはダイバージェンス(発散)が含まれますが、これは本質的に、GPU内の各スレッドが独自のニューラルネットワークにテクセル値を問い合わせ/実行する場合、これらのスレッドは一緒に動作することを意図しているため、ダイバージェンスを克服しなければならないことを意味します。

つまり、実行ダイバージェンスとデータダイバージェンスの両方があります。

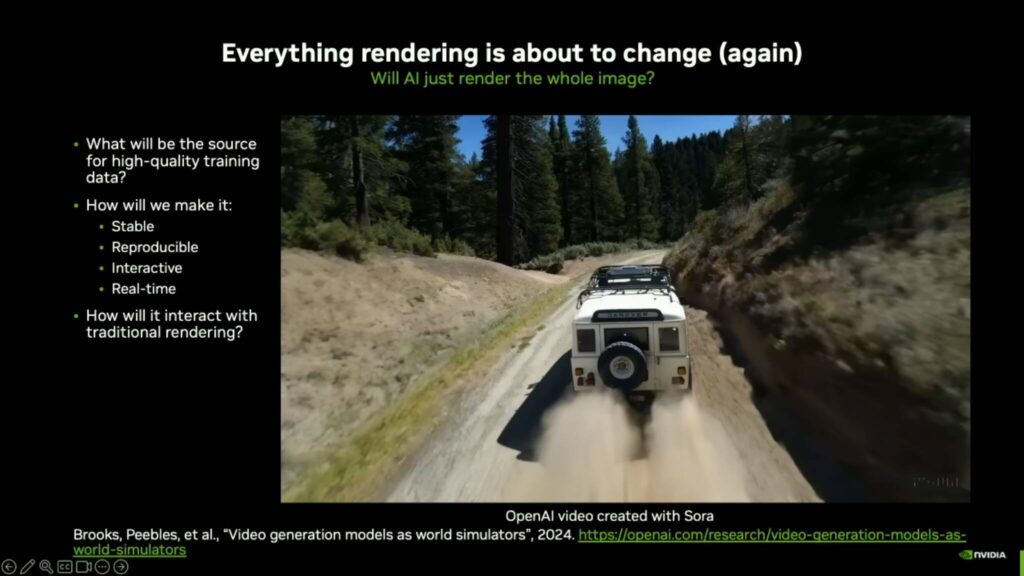

AIを使った未来のレンダリングの例として、Soraを使って作成された最近のOpenAIの動画が紹介されている。

この動画では、ジープが険しい未舗装の地形を走り抜け、リアルな砂埃の軌跡が残され、車両が地形に基づいたリアルな重量とシミュレーションを披露している。

これは完全にAIが作成したビデオで、ゲームなどAIの将来の応用を垣間見せてくれる。

この小さなアニメーションは、小さなテキストプロンプトを使って学習させるために何万ものGPUを要したが、AIのハードウェアがより強力になるにつれて、おそらく数年後にはコンシューマー向けGPUに搭載されるようになるだろう。

このセッションで他に興味深かったのは、NPU対GPUのような専用ハードウェアの使用に関するコメントや、将来のGPUに統合されるかもしれない他のアクセラレータに関するコメントだった:

GPUに結びついていない専用ハードウェアの問題点は、使用しているニューラルネットワークの周りのすべてのことを行うために使用できるエコシステム全体を失ってしまうことです。そのため、私たちは、SM上でプログラム可能なコードを実行した後、Tensorコアに移動し、特定の問題に対して必要であれば何度でも戻ることができるように、かなり緊密に結合させることを好んでいます。

将来の製品については何も話したくないが、ニューラル・アピアランス・モデルが形成され、機能し始めるのを見るまでは、マテリアルを高速化する方法について多くの時間を費やしてきた、 入力が50もあるような複雑なものでも、専用のハードウェアを作れば、モンテカルロ法を使ったマルチレイヤーサンプルや、ポジションフリーのモンテカルロ法を使うことができる。次の破壊は、ハードウェアを必要とせずに次のステップを踏み出すために、私たちが可能にした通行料を使うことだと思います。ニューラル・アピアランス・モデルはその良い例だと思います。

ジョン・バージェス – NVIDIA

テクノロジーが無限の可能性を提供してきたことを考えると、計算の世界に対するAIの影響力はまだ測り知れないと言ってよく、グラフィック計算に対するその影響力は、潜在的な能力のほんの一例である。

ニューラル・アピアランス・モデルとRay Reconstructionにより、次世代グラフィックスは、かつて我々が夢見た地点に確実に到達する。

解説:

NVIDIAの次期ゲーム技術はDLSS4ではなく、レイトレーシングをAIを使って高速化すること。

AIを使って性能を底上げするのはアップスケーリングとフレーム生成で打ち止めのようですね。

GPUによりレイトレーシングはCPUのそれと比較してノイズが乗ることがあるのが欠点です。

しかし、Ray Reconstructionでノイズの乗らない画像をリアルタイムでレンダリングできるようになるようです。

また、AIを使ったテスクチャの超高圧縮、レイトレーシング画像のノイズ除去などが次世代のゲーム技術の根幹をなすようです。

今までのDLSSはレンダリングされた後の画像を一括で処理していましたが、これからはレンダリングする前の工程にAI技術を投入していくということのようです。

その工程は主にレイトレーシングの高速化に使われるというのがざっくりとした概要のようですね。

また、ラスタライズにも応用できるのかどうかまではわかりませんが、テクスチャを超高圧縮することもできるようですから、メモリの節約や性能の向上に大きく役立つことと思います。

DLSSとハードウェアレイトレーシングアクセラレーターは分離して使うことも可能でしたが、次世代の技術はレイトレーシングの性能を向上させるように作られており、不可分のものであるように思います。

ラスタライズに応用できれば、低価格帯のPCでも3Dのゲームが楽しめるようになると思いますのでちょっと残念ですが、NVIDIAが最初のRTXであるTuringからレイトレーシングを志向していたことを考えると当初の計画通りということなのでしょうね。

NVIDIAによると、最終的にはキャラクターやオブジェクトをAIによって生成することになるようですから、レイトレーシングの処理を高速化したら、今度は個別のオブイジェクトにAI処理の焦点が移っていくのかもしれません。

あとはAMDやIntelがどのくらい追従できるのかということです。

DLSS3のフレーム生成からAMDは2年でAIによるフレーム生成処理を搭載できました。

Intelはまだ実装していません。

今度のレイトレーシングのデノイジングとテクスチャ圧縮はどの程度まで追従できるでしょうか。

nVidia RTX4000SUPER

nVidia RTX4000

nVidia RTX3000シリーズGPU

RTX3060 12GB GDDR6

RTX3050 6GB

Copyright © 2024 自作ユーザーが解説するゲーミングPCガイド All Rights Reserved.